Nel weekend tra il 22 e il 24 febbraio si è tenuto presso la Scuola Open Source il corso di Analisi e Visualizzazione delle Reti Sociali.

Affrontare gli aspetti teorici delle complex networks utilizzando anche strumenti di acquisizione e analisi dati richiede al giorno d’oggi un’interdisciplinarietà che purtroppo è difficile trovare nei corsi universitari.

Nell’Accademia i programmi sono spesso statici nel tempo, difficili da aggiornare, e vincolati a una iper-specializzazione che li rende fortemente limitati nel tentativo di stare al passo con un mondo in costante accelerazione. Anche per questo motivo, spazi e progetti come quello di SOS, sono utili esperimenti per elaborare nuove metodologie, che si scontrano anche con il dilemma di trovare linguaggi adatti, in partenza, ad un pubblico eterogeneo anche nel background di formazione.

Nelle giornate del corso erano presenti persone provenienti da differenti percorsi, ma tutte interessate a portare nei relativi campi l’utilizzo di strumenti di network analysis.

Abbiamo iniziato con un rapido riepilogo del ruolo nella sociologia dell’analisi delle reti sociali, ripercorrendo i dibattiti che ne hanno accompagnato lo sviluppo, come la critica alla quantificazione nelle scienze sociali o la dicotomia attore/struttura. Già in questo contesto, partendo dalla sociometria di Moreno e poi dal celebre esperimento di Milgram, abbiamo parlato dei 6 gradi di separazione, la teoria secondo la quale, se prendiamo due persone a caso, tra queste ci sono al massimo 6 passaggi di amicizia di distanza. La distanza massima, detta diametro di una rete, è stata riscontrata essere pari a 4,5 nel caso del network di amicizie di Facebook, mentre per passare da una pagina web ad un altra seguendo i passaggi di link pare che al massimo occorrano 19 step.

Studiando la topologia e le statistiche legate alla struttura di una network abbiamo provato a capire le differenze sistemiche tra diversi modelli organizzativi e di comunicazione, affrontando cosa sia una rete random rispetto ad una scale-free, nella quale la distribuzione dei link associati ad ogni nodo mostra un andamento esponenziale negativo, dove cioè pochi nodi possiedono un altissimo numero di link (hub) contrariamente a una grandissima percentuale di nodi dalle poche connessioni, riportando sul piano delle relazioni una configurazione di distribuzione del valore caratteristica delle società capitalistiche (Legge di Pareto 80/20).

Per provare a mettere mano nell’analisi di una rete reale, abbiamo optato per studiare la rete sociale delle pagine Facebook a partire dalla pagina della SOS.

Scaricare dati dai social non è semplice, per quanto siamo noi a produrre contenuto. Le API sono librerie che consentono agli sviluppatori di ottenere informazioni da parte di una piattaforma secondo le regole di questa. Lo scraping, invece, è la pratica di automatizzazione dell’acquisizione dati che potremmo fare anche a mano in molto più tempo.

In generale, abbiamo quindi fatto una panoramica dei tools utili per ottenere dati dai social network (il più facile per policy e interfaccia è Twitter, segue Facebook e infine Instagram). Tra questi, abbiamo utilizzato principalmente Netvizz, un’app che permette – tra le altre cose – di scaricare la rete di “amicizie tra pagine”, ovvero il network costituito dalle pagine che mettono il like ad una determinata pagina, e quelle che hanno messo il like a queste. Ovviamente, questo è possibile in quanto la policy sulle pagine è meno restrittiva rispetto a quella sulle relazioni di utenti.

Netvizz offre inoltre la possibilità di scegliere la profondità della rete da scaricare. 1-depth per avere la rete degli “amici di SOS” e 2-depth per quella degli “amici e amici degli amici”.

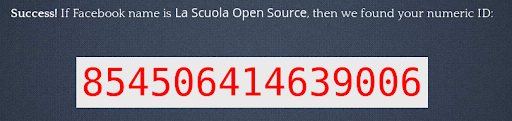

Come primo tentativo, abbiamo quindi cercato l’ID di SOS e scaricato la rete ad una profondità.

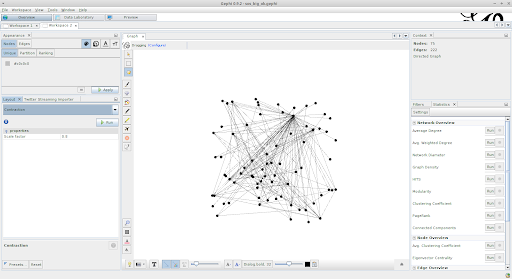

Quello che otteniamo è un file che possiamo aprire con Gephi, un utile software open source che consente di svolgere analisi di base sulle reti senza necessariamente saper usare codici particolari. La rete scaricata conta 75 nodi (pagine) e 222 link (“mi piace”), e si presenta inizialmente come un confuso groviglio di linee e punti.

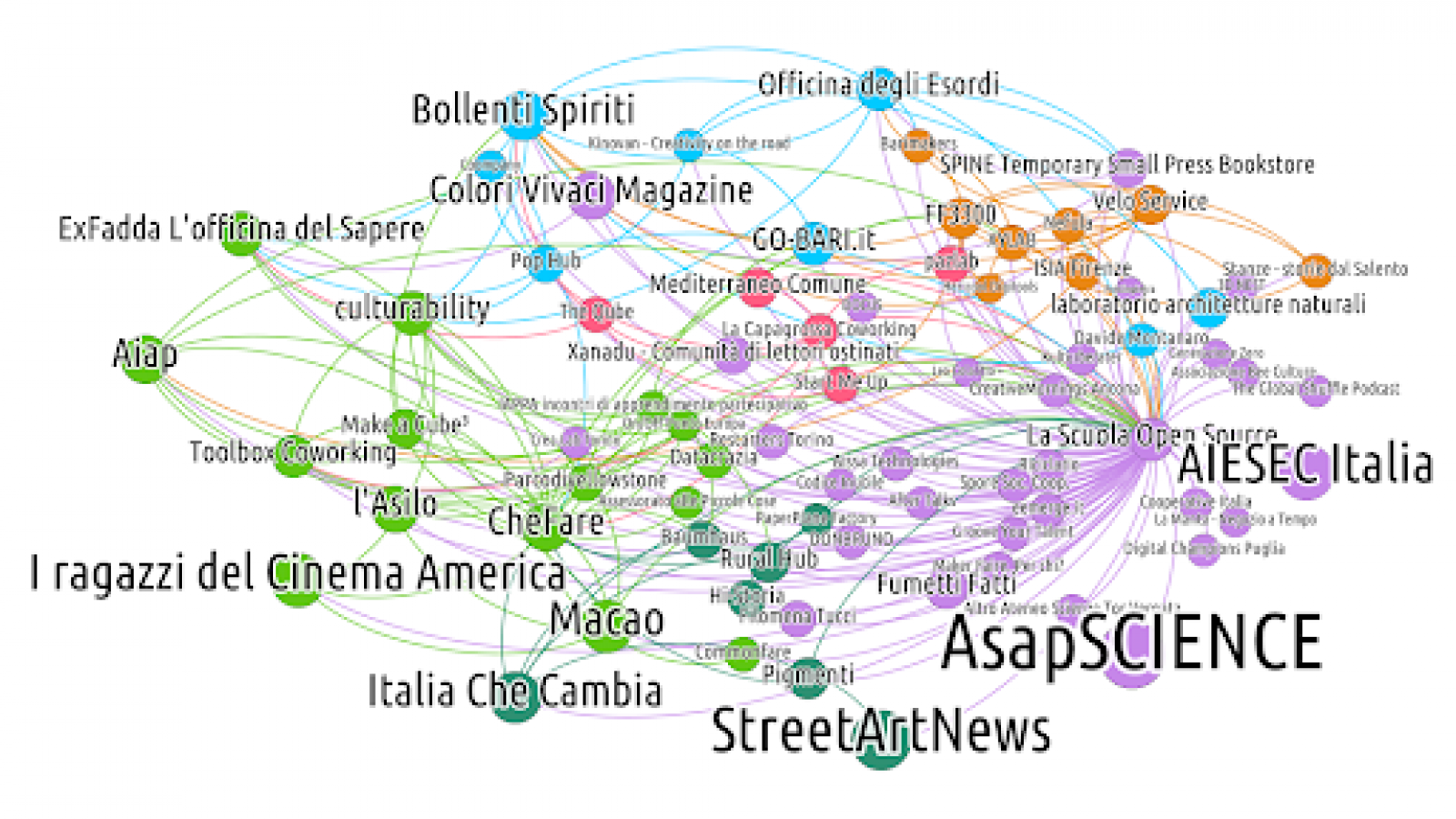

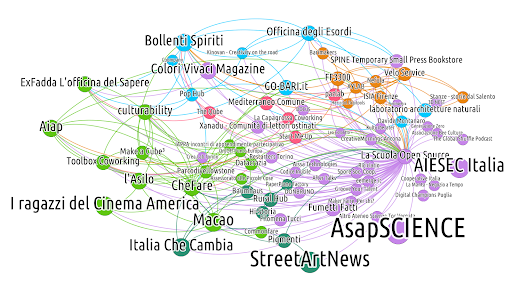

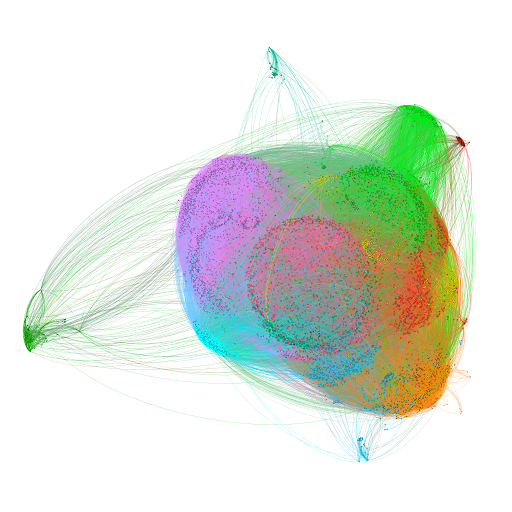

Su questa rete, abbiamo svolto le analisi statistiche basilari introdotte nel corso: centralità, densità, PageRank e clustering. Tramite quest’ultimo è stato possibile suddividere i nodi in gruppi di “maggiore relazione reciproca”, le bolle sociali più strette internamente. Colorando diversamente ogni “bolla” si è ottenuto qualcosa di questo tipo:

È già evidente fin da qui la presenza di bolle legate al panorama cittadino e culturale di Bari (azzurro), un’altra (verde) geograficamente distribuita ma progettualmente affine degli spazi sociali – mai sentito parlare dell’#Orgia? :) - oltre a altre realtà sparse e meno legate tra loro.

Per compiere analisi più approfondite con maggiori informazioni, abbiamo scaricato da Netvizz anche la rete a profondità 2, impiegandoci parecchi minuti per ottenere il file dall’app. Quello che ci siamo trovati davanti a questo punto era la bellezza di 8.752 nodi e 123.831 link, suddivisi successivamente in 11 clusters, in una disposizione visuale già di pèr sé affascinante.

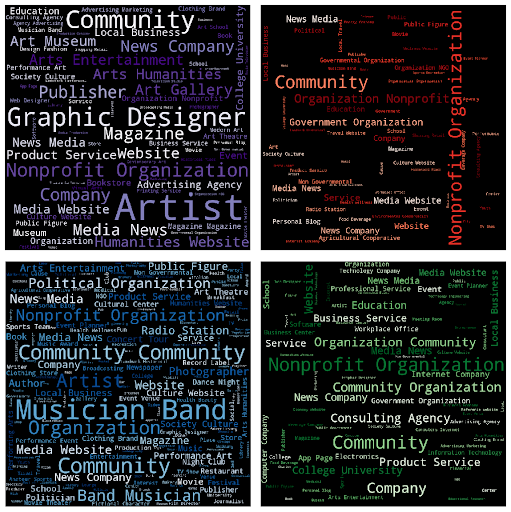

La suddivisione compiuta da Gephi nel calcolare i vari clusters deriva però esclusivamente da proprietà di rete, cioè osservando quali gruppi sono internamente più coesi rispetto il resto del network. Netvizz, tra le altre cose, ci fornisce anche la categoria di ogni pagina, così che noi siamo riusciti a studiare la distribuzione delle categorie internamente ad ogni cluster, cercando così di identificarle anche dal punto di vista categoriale. A partire da queste, costruendo delle “cloud word” di categorie, troviamo così gruppi di arte visiva, di comunità politica, del mondo musicale o delle organizzazioni sociali.

Dopo questi rapidi esperimenti di analisi, per navigare nella rete nella sua totalità, abbiamo usato il plugin Sigma, che permette di esportare in un formato implementabile in una pagina html, oltre che poter navigare tramite campo di ricerca.

È buffo che tra i tanti soggetti effettivamente legati a SOS, tra i nodi compaiano anche Barack Obama, Google o Victoria’s Secret. Questo è evidentemente una dimostrazione di quel fenomeno “small world” di cui si parlava all’inizio, che anzi su un social network virtuale è ancora più accentuato che nella realtà, poiché spesso chiediamo amicizia o mettiamo like a persone o strutture con cui non abbiamo costruito reali rapporti.

Tuttavia, anche queste relazioni fittizie, sono interessanti per quanto riguarda l’ambito di interesse, tecnologico o artistico a seconda dei casi, perché possono servire a guidarci per potenziali nuovi contatti da costruire, o svelare relazioni implicite. Studiare le reti al tempo della Rete può essere allora anche un modo per analizzare la propria bolla, soffermarsi sul confine, ed escogitare strategie per costruire nuove relazioni.

Quello che resta da tre giorni intensi come questi, è che le strade percorribili in una didattica sui nuovi mezzi di comunicazione sono praticamente infinite. Abbiamo avuto modo solo di accennare a librerie di Python, algoritmi di scraping, dataset disponibili già online utili per studiare la società attuale (uno dei prossimi target che ci siamo dati è quello di studiare l’impatto di AirBnB a partire da piattaforme che ne condividono le statistiche…). Tutto il materiale utilizzato e le analisi compiute durante il corso erano condivise in tempo reale tra i partecipanti, in modo da collaborare costantemente ai progetti.

Possiamo dire quindi che questo weekend è stato uno tra i tanti esperimenti per elaborare una didattica nuova, interdisciplinare, caotica, adatta alla tempolinea accelerata in cui viviamo.

scritto da Daniele Gambetta